Pragmatische KI für weniger Bias und mehr Fairness

Über Felix Friedrich

Felix Friedrich forscht am Fachbereich Informatik an der Technischen Universität Darmstadt. Er studierte Elektrotechnik an der TU Dortmund und hält zwei Masterabschlüsse von der TU Darmstadt in Autonome Systeme sowie Informatik mit Nebenfach in Psychologie.

Seit 2021 promoviert Friedrich am Machine Learning Lab am Fachbereich Informatik der TU Darmstadt.

AI Kognition und maschinelle Intelligenz

Wie denkt und lernt der Mensch? Die Frage der menschlichen Kognition lässt sich auf künstliche Intelligenz übertragen und ist gar ein entscheidendes Element in der Nachvollziehbarkeit von KI-Systemen. Wieso trifft ein KI-System etwa eine bestimmte Entscheidung und wie lässt sich der Entscheidungsweg erklären, sodass sie ein Mensch auch versteht?

Friedrich erklärt, dass KI-Systeme häufig Abkürzungen verwenden und dadurch Scheinkorrelationen entstehen. Als Beispiel nennt er die maschinelle Erkennung von Hunden und Wölfen: Befindet sich das zu erkennende Tier in einem Wald, wird das KI-System wahrscheinlich einen Wolf erkennen, in einem häuslichen Kontext jedoch einen Hund.

Deshalb sind KI-Systeme stark auf menschliches Feedback angewiesen – und je besser man verstehe, wie die Maschine funktioniert und die Fehler liegen, desto besser verstehe man die Potenziale von KI-Systemen, um sie zu verbessern.

Friedrich betont den Pragmatismus, der seine Forschung auszeichnet: „Wir haben heute eine gute Vorstellung davon, was KI macht und wieso. KI ist aber nicht perfekt. Wenn wir immer mehr verstehen, wie sie funktioniert, bleibt trotzdem die Frage, wie die Systeme genutzt werden. Und man muss sie verbessern.“

Großes Verbesserungspotenzial sieht Friedrich in Fairness und Bias von KI-Modellen. Oft geben etwa Diffusionsmodelle wie Bildgeneratoren bei bestimmten Alters-, Berufs- und Geschlechtsangaben immer dieselben Bilder aus: Der Banker ist häufig ein weißer Mann im Anzug, die Pflegefachkraft eine Frau und das Kind aus Afrika in armen Verhältnissen.

„Die Merkmale des Aussehens in generierten Bildern spiegeln nicht unbedingt die Realität wider“, sagt Friedrich. Wie bekommt man also mehr Diversität rein, und Vorurteile sowie Schönheitsideale raus?

Friedrich betont den Pragmatismus, der seine Forschung auszeichnet: „Wir haben heute eine gute Vorstellung davon, was KI macht und wieso. KI ist aber nicht perfekt. Wenn wir immer mehr verstehen, wie sie funktioniert, bleibt trotzdem die Frage, wie die Systeme genutzt werden. Und man muss sie verbessern.“

KI-Modelle seien ähnlich, etwa hinsichtlich Differenzen in kulturellen Faktoren. Zwar lässt sich mit gezielten Eingabeaufforderungen („Prompts“) dagegen steuern, allerdings lösen diese nicht immer das Problem der Stereotypen oder führen gar andere Stereotypen ein.

Bias-Reduktion ist ein Balanceakt

Friedrich betont dabei eine Kernproblematik: Normative Begriffe wie „richtig“ und „falsch“ oder „gut“ und „schlecht“ ließen sich schlecht in KI-Modellen beweisen: „Es ist quasi nicht möglich, ein KI-Modell zu trainieren, das keine Biases hat. Man muss jedoch schauen: Wo entsteht dadurch ein Schaden und wie kann man das verhindern?“

Ein gewisser Einfluss sei möglich, sagt Friedrich: „Hätte man ein KI-Modell vor 20 Jahren trainiert, wäre eine Frage, ob es gut ist, nach New York zu fliegen, wahrscheinlich positiv aufgefasst worden. Heute würde das KI-Modell wahrscheinlich kritischer mit dieser Frage umgehen, weil der Kontext sich verändert hat. Der KI beibringen, derartige Kontexte eigenständig zu verstehen. Ein Verständnis für normative Werte erzeugen.“

Das Trainieren von eigenen KI-Modellen ist aufwendig und kostenintensiv und nur für wenige Unternehmen durchführbar. Für Friedrich ist ein Lösungsweg, moralische Werte in einem KI-Modell zu überschreiben, also auf eine persönliche Vorstellung trimmen.

In der Fachsprache nennt man dies „revision corpus“: Das Wissen des KI-Modells verändert sich nicht, es wird nur anders abgefragt. Dabei kommt es auf die Genauigkeit der Sprache an. Dabei kommt es auf die Genauigkeit der Sprache an.

Friedrich erkennt hier erneut Parallelen zum Menschen, etwa bei Erklärungen und Urteilen anhand ähnlicher Fälle, Beispiele und Situationen.

„Die Herausforderung ist die normative Frage: Was ist richtig und was ist falsch? Überschreibe ich damit vielleicht auch andere Werte, die ich nicht überschreiben will? Es ist unfassbar schwierig, Biases zu entfernen oder zu verringern, ohne neue Biases einzufügen.“

Fehlertoleranz und Pragmatismus in der KI-Entwicklung

Mit „Fair Diffusion“, einem angepassten Diffusionsmodell, haben Friedrich und sein Team einen Bildgenerator entwickelt, der die Merkmalsvorurteile verringern soll.

KI-Modelle generieren etwa häufig blondhaarige und weibliche Menschen, obwohl sie weltweit unterrepräsentiert sind. „Fair Diffusion“ hilft eine gerechtere Verteilung der Geschlechter zu realisieren. Gleichzeitig können auch andere Attribute wie Hautfarbe, Haarlänge oder Ähnliches beeinflusst werden.

Vorurteile aus KI-Modellen ganz zu entfernen? Ein wahrscheinlich unmögliches Unterfangen.

Diese ethischen Abwägungen sind ein zentraler Bestandteil von Friedrichs Forschung. Der Forscher appelliert erneut an den menschlichen Pragmatismus: Bei Menschen seien Risiken, etwa im Straßenverkehr, zu erwarten. Deshalb sei es falsch von Maschinen zu erwarten, dass sie niemals Fehler begehen dürfen.

„Man muss auf jeden Fall eine Fehlertoleranz haben. Das Risiko sollte man aber trotzdem minimieren. Das ist oberstes Gebot“, sagt Friedrich.

Die Frage nach Kausalität oder Korrelation hat für Friedrich gesellschaftliche Implikationen: „Wer bestimmt eigentlich, wie die Welt aussehen soll, die ein KI-Modell widerspiegelt?“ Es sei eine große Herausforderung, wenn wenige große Unternehmen KI-Modelle besitzen, die übergreifend bestimmen, wie KI Modelle funktionieren und welche Werte sie repräsentieren.

Mit seiner Forschung wirkt Friedrich diesen Fragen entgegen. Eine aktuelle Arbeit wurde im renommierten Fachjournal „Nature Machine Intelligence“ angenommen, ein großer Erfolg für den jungen Forscher.

Ohnehin stoßen seine Arbeiten in Fairness und Biases auf sehr positives Feedback in der Community, etwa Fair Diffusion: „Meine Arbeit hat einen gesellschaftlichen Nutzen und hohe Relevanz. Das gibt mir sehr viel Sinn in meinem Alltag“, sagt Friedrich.

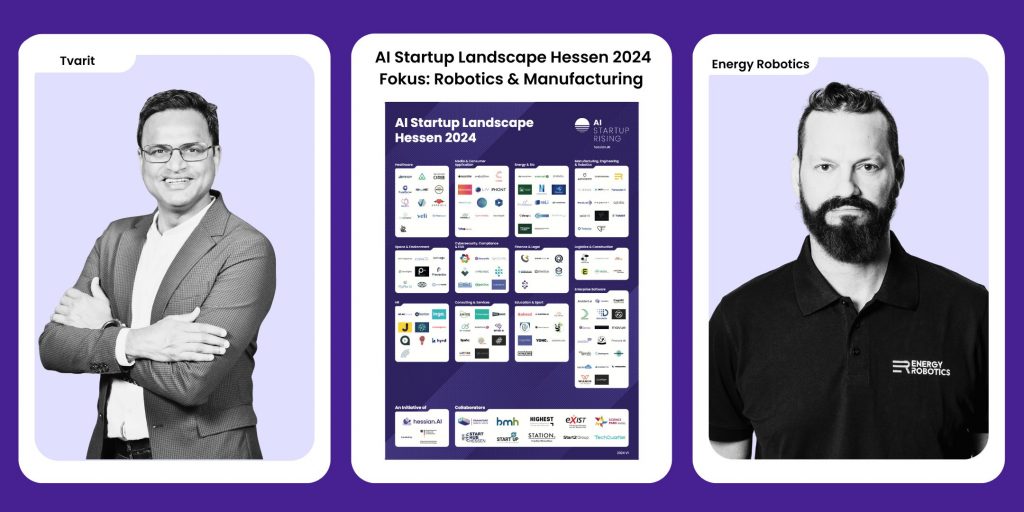

Dabei schätzt Friedrich das Forschungsnetzwerk und die Infrastruktur von hessian.AI | The Hessian Center for Artificial Intelligence : „Die Infrastruktur von hessian.AI | The Hessian Center for Artificial Intelligence sucht deutschlandweit ihresgleichen. Hier kann man kann auf dem neuesten Stand forschen, unterstützt durch ein einzigartiges Netzwerk an Forschenden und Professoren.”