Warum neuronale Netze katastrophal vergesslich sind

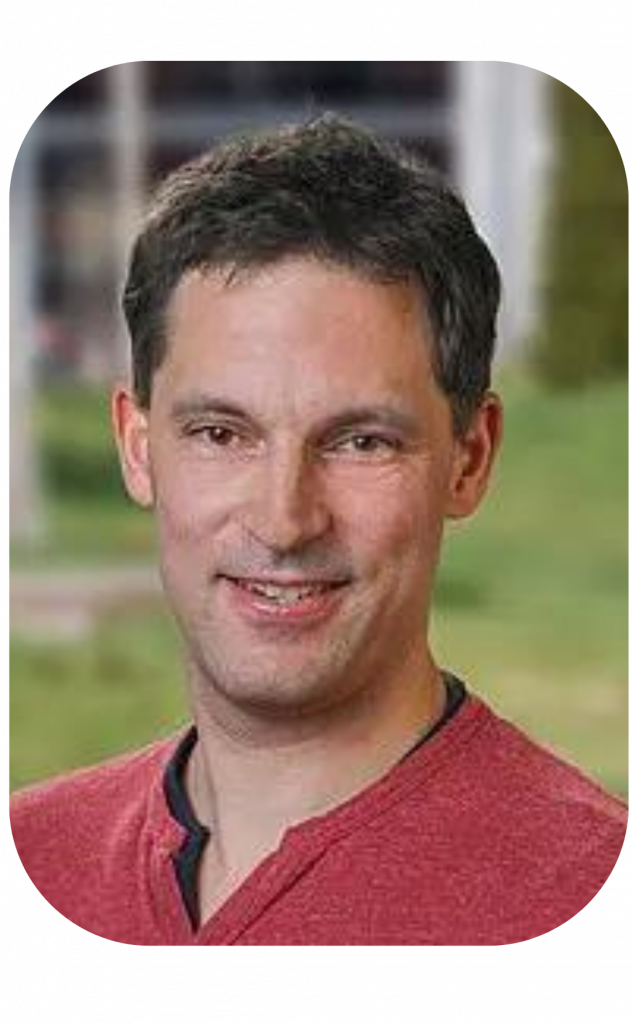

Über Prof. Dr. Alexander Gepperth

Prof. Dr. Alexander Gepperth ist Professor für Programmierung und Machine Learning im Fachbereich Angewandte Informatik der Hochschule Fulda.

Gepperth studierte Physik an der Ludwig-Maximilians-Universität München und wechselte für seine Promotion an das Institut für Neuroinformatik der Ruhr-Universität Bochum. Dort forschte der Wissenschaftler in der Abteilung Fahrerassistenz an neuronalen Lernverfahren zur visuellen Objekterkennung.

Nach seiner Promotion im Jahr 2006 arbeitete Gepperth am Honda Research Institute Europe GmbH, wo er als Senior Scientist an der Grundlagenforschung zum Lernen im Fahrzeug und an der Realisierung von Prototypen beteiligt war

2011 kehrte Gepperth an die Universität zurück: Bis 2016 war der Wissenschaftler Professor an der ENSTA ParisTech in Frankreich und unter anderem für den Spezialisierungsstudiengang „Intelligentes Fahrzeug“ verantwortlich.

2016 folgte Gepperth dem Ruf an die Hochschule Fulda.

Wie künstliche neuronale Netze gründlicher lernen sollen

Gepperth forscht an neuronalen Netzen zur Objekt- und Bilderkennung. Ein Thema, das ihn seit seiner Promotion begleitet. In den vergangenen zehn Jahren hat er sich auf das kontinuierliche Lernen konzentriert. „Das ist das, was wir Menschen die ganze Zeit machen. Deswegen ist es schwierig, jemanden zu erklären, dass es etwas Besonderes ist“, so Gepperth.

Selbst die besten Deep-Learning-Methoden scheitern heute am kontinuierlichen Lernen für Maschinen. Ein Beispiel: Ein Klassifikator hat gelernt, Katzen zu erkennen. Soll das Netz nun lernen, auch Hunde zu erkennen, muss es komplett neu trainiert werden – oder es vergisst alles, was es bereits gelernt hat. In der Forschung nennt man das „katastrophales Vergessen“. Kontinuierliches Lernen soll Abhilfe schaffen.

Gepperth forscht an diesem grundlegenden Problem. Mit seinem Team entwickelt er neue Konzepte für kontinuierliches Lernen. So veröffentlichte er im März 2022 ein Paper über die algorithmischen Grundlagen des Lernens mit konstanter Zeitkomplexität.

Neuronale Netze und Zeitkomplexität

Die größte Herausforderung sieht Gepperth in der zeitlichen Komplexität: In biologischen Gehirnen gebe es Mechanismen, die verhindern, dass wir alles vergessen, wenn wir etwas Neues lernen – egal, wie viel wir schon wissen.

Im Machine Learning könnten einige Methoden das katastrophale Vergessen verhindern, etwa das Einfrieren bestimmter Teile des neuronalen Netzes. Doch mit diesen Methoden dauert das Lernen über Zeit umso länger, je mehr das Netz schon weiß, sagt Gepperth.

Er sucht daher nach Methoden, die das Gelernte schützen können, ohne vom bereits Gelernten abhängig zu sein. Eine wissenschaftliche Arbeit seines Teams zu dem Thema wurde kürzlich auf der CVPR eingereicht, einer der wichtigsten Konferenzen für Computer Vision.

Roboter, die neue Gesichter lernen und das Big Picture

hessian.AI unterstützt Gepperth in seiner Forschung. Das Zentrum biete Austausch zu erstklassigen Forschenden und eine wissenschaftliche Community, in der zum Beispiel Fragen zum Begutachtungsprozess oder Problemlösungen für Nachwuchswissenschaftlerinnen und -wissenschaftler diskutiert werden.

Dabei zählt auch das Big Picture: „Ist das, was ich mache, überhaupt sinnvoll“ sei eine Frage, die Forschende dank der Community besser beantworten könnten.

Im Falle des kontinuierlichen Lernens ist die Antwort eindeutig: Ja. Fortschritte in dieser Technologie würden den breiten Einsatz von KI-Systemen ermöglichen, sagt Gepperth. „ Systeme, die nicht dazu lernen können, müssen irgendwann komplett neu trainiert werden.“

Kontinuierlich lernende Systeme hingegen benötigen weniger Wartung und Training. Roboter könnten beispielsweise leicht lernen, neue Gesichter zu erkennen.

Die gleichen Methoden ermöglichen auch das selektive Vergessen in neuronalen Netzen – eine wichtige Fähigkeit für Fragen des Datenschutzes und der Privatsphäre.