Die Blackbox knacken: Verstehen und Verhindern von katastrophalem Vergessen in der KI

Über Roshni Kamath

Roshni Kamath ist Doktorandin an der Technischen Universität Darmstadt. Sie hat einen Bachelor-Abschluss in Informatik-Softwaretechnik an der Universität von Mumbai und einen Master-Abschluss in künstlicher Intelligenz an der Katholieke Universiteit (KU) Leuven.

Bevor sie im Juni 2022 zur Forschungsgruppe Open World Lifelong Learning an der TU Darmstadt kam, arbeitete sie als Softwareentwicklerin und war KI-Forscherin am Forschungszentrum Jülich.

Nachahmung menschlichen Lernens in der KI

Stellen Sie sich vor, Sie lernen ein Musikinstrument zu spielen Mit jedem Fortschritt lernen Sie neue Lieder und Techniken. Gleichzeitig werden Sie sich wahrscheinlich an die Stücke, die Sie zuvor gelernt haben, erinnern und sie spielen können.

Diese Fähigkeit, Wissen und Fertigkeiten im Laufe der Zeit zu erwerben und zu behalten, ist ein grundlegender Aspekt des menschlichen Lernens. Um diese Fähigkeit auch auf KI-Systeme zu übertragen, konzentriert sich Kamaths Forschung auf „kontinuierliches Lernen in der KI“.

Ihr Ziel ist es, die Mechanismen von KI-Modellen besser zu verstehen und sie so zu optimieren, dass sie neue Informationen effizient in vorhandenes Wissen einbeziehen und so ihre Leistung im Laufe der Zeit verbessern.

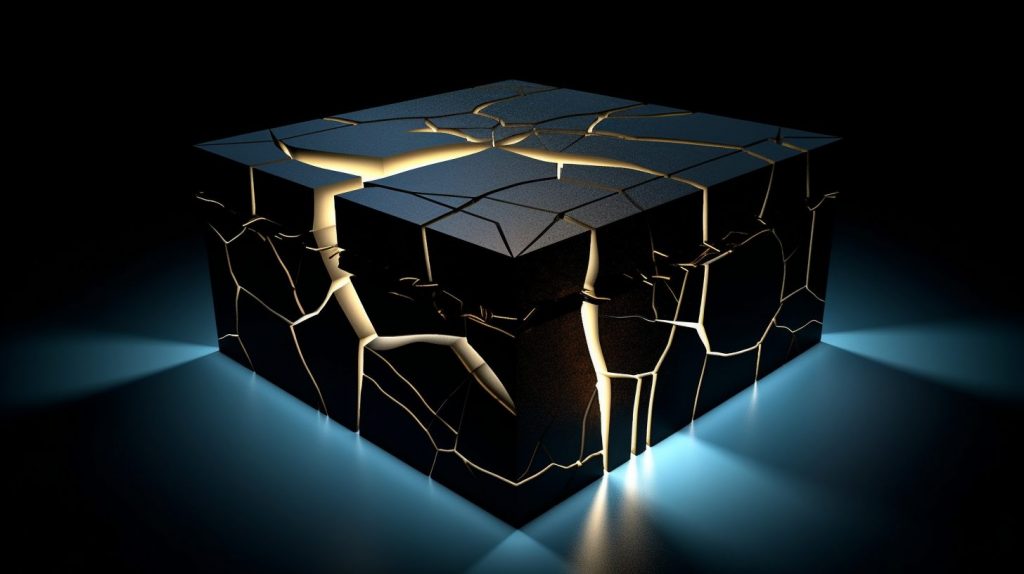

Ein Aspekt ihrer Forschung befasst sich mit einer großen Herausforderung beim kontinuierlichen Lernen: „katastrophales Vergessen“. Wenn ein Modell, das für eine Aufgabe trainiert wurde, mit neuen Daten für eine andere Aufgabe konfrontiert wird, kann es vergessen, was es gelernt hat. Dies führt zu einem Leistungsabfall. Kamaths Forschung konzentriert sich darauf, dieses Phänomen zu verstehen und Wege zu finden, es zu verhindern.

Wenn beispielsweise ein Modell mit Hirnbildern aus verschiedenen Krankenhäusern trainiert wird, können sich Unterschiede in der Auflösung, den Metadaten und dem Aufnahmeverfahren auf die Modellleistung und das katastrophale Vergessen auswirken. Kamath möchte über die einfache Messung der Genauigkeit eines KI-Modells hinausgehen und sich auf die vielfältigen Faktoren konzentrieren, die das Lernen und Vergessen beeinflussen können – ein Ansatz, der dem echten Leben ähneln soll.

„Das Ziel meiner Arbeit ist es, neue Techniken zu entwickeln und Verbindungen zwischen verschiedenen Paradigmen des maschinellen Lernens herzustellen“, sagt Kamath. Ihr Ziel ist es, fortschrittliche KI-Systeme zu entwickeln, die in der Lage sind, in einer unbegrenzten Umgebung selbstständig zu lernen. Diese Systeme können kontinuierlich lernen, neue Situationen erfolgreich erkennen und entscheiden, welche Daten für das Training verwendet werden sollen.

In diesem Zusammenhang geht es bei Kamaths Forschung darum, den Modellen etwas über sich selbst, die Daten, auf denen sie trainiert wurden, und ihre Fähigkeiten beizubringen. Dies ist Teil der Schaffung eines Rahmens für Modelle zur Verhinderung des katastrophalen Vergessens in Szenarien des lebenslangen Lernens in der offenen Welt.

Kontinuierliches Lernen in der KI voranzutreiben ist ein Balanceakt

Für Kamath bedeutet dies, verschiedene Ansätze auszubalancieren und eine ganzheitliche Sichtweise einzunehmen. Durch Transferlernen können KI-Modelle beispielsweise Wissen aus früheren Problemen nutzen, wenn sie vor neuen Herausforderungen stehen. Durch die Übertragung von Wissen zwischen Aufgaben können sich KI-Systeme effizienter an neue Daten und Situationen anpassen, ohne bei Null anfangen zu müssen.

Kamath zufolge kann dies auch zu Bedenken führen, zum Beispiel beim Datenschutz. Sie merkt an: „In einem Krankenhaus sind viele Patienten nicht damit einverstanden, ihre Daten zu speichern oder weiterzugeben. Bei der Feinabstimmung eines Modells für eine neue Aufgabe durch die Übertragung von Wissen besteht die Gefahr, dass versehentlich Informationen aus früheren Aufgaben durchsickern, selbst wenn diese anonymisiert oder ursprünglich nicht sensibel waren.

Ihre Forschung zielt darauf ab, ein Gleichgewicht zu finden, insbesondere im Hinblick auf die Auswirkungen des lebenslangen Lernens in KI-Systemen auf den Energieverbrauch. Die Verbesserung der Leistung von Modellen kann zu Energieeinsparungen und nachhaltigeren KI-Systemen führen, insbesondere wenn es sich um groß angelegte maschinelle Lernmodelle handelt, die erhebliche Rechenressourcen erfordern.

So kann beispielsweise das Transfer-Lernen die für jede neue Aufgabe benötigte Trainingszeit und die Rechenressourcen reduzieren, indem bereits trainierte Modelle oder gemeinsames Wissen zwischen den Aufgaben verwendet werden, was Energie sparen kann.gy. Kamath nimmt regelmäßig an Treffen des hessischen KI-Netzwerks teil, um Ideen mit anderen Forschern auszutauschen und sich über deren Herausforderungen zu informieren. Diese Interaktionen liefern wertvolle Einblicke in die Fragen der KI-Gemeinschaft und ermöglichen es ihr, ihre Forschung zu verbessern und zu fokussieren, um die Entwicklung des kontinuierlichen Lernens in der KI voranzutreiben.