Research & Application – 3rd wave of AI

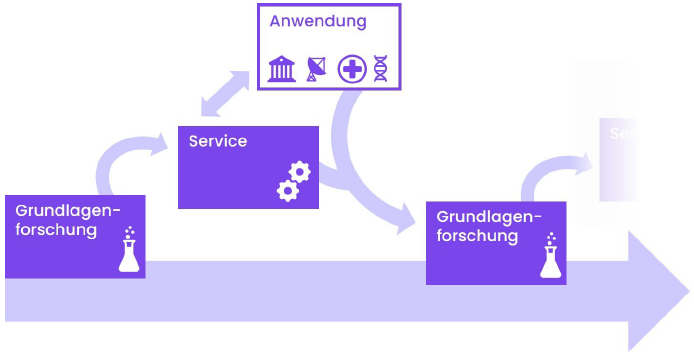

Die Forschungsaktivitäten des hessischen KI Servicezentrums dienen dazu, eine Brücke von der KI-Forschung zur Anwendung zu schlagen und die Marke “KI made in Germany” zu stärken. Hierbei liegt der Fokus darauf, die Ergebnisse unserer Grundlagenforschung in Services und Anwendungen zu überführen, aus welchen sich wiederum neue Fragestellungen für die Forschung ergeben.

Das Servicezentrum arbeitet hierbei eng mit den Forschenden von hessian.AI, dem öffentlichen Dienst und den hessischen Unternehmen zusammen, um mit Demonstratoren und direkt anwendbaren Modellen die Hürde für den Einstieg in die Anwendung von künstlicher Intelligenz zu senken.

Die weitgefächerten Weiterbildungs- und Serviceangebote unterstützen die Nutzenden zusätzlich bei der Anwendung der bereitgestellten Forschungsergebnisse.

Forschungsschwerpunkte

Das hessische KI Servicezentrum konzentriert sich im Rahmen der 3. Welle von KI auf

- große verallgemeinerbare Modelle

- Transparenz & Erklärbarkeit

- kontextuelle Adaption

- Ausnutzung spezifischer (Netzwerk-)Strukturen

mit dem Ziel, robuste, sichere und nachhaltige KI-Systeme für ein breites Spektrum von Nutzern zu entwickeln und bereitzustellen.

Datensätze, Modelle und Demonstratoren

Im Rahmen der bisherigen Forschung des KI Servicezentrums wurden die nachfolgenden Modelle entwickelt, trainiert und als Demonstratoren durch hessian.AI bereitgestellt:

V-LoL Datensatz – Visual Logical Learning

Trotz der Erfolge jüngster Entwicklungen in der visuellen KI bestehen weiterhin verschiedene Mängel: von fehlender exakter logischer Schlussfolgerung über abstrakte Generalisierungsfähigkeiten bis hin zum Verständnis komplexer und verrauschter Szenen.

mehr lesen

Leider sind bestehende Benchmarks nicht darauf ausgelegt, mehr als nur wenige dieser Aspekte abzudecken. Während Deep-Learning-Datensätze visuell komplexe Daten, aber einfache visuelle Aufgaben fokussieren, beinhalten induktive Logik-Datensätze komplexe logische Lernaufgaben, denen jedoch die visuelle Komponente fehlt. Um dies zu adressieren, schlagen wir den visuellen logischen Lerndatensatz V-LoL vor, der nahtlos visuelle und logische Herausforderungen kombiniert. Insbesondere stellen wir die erste Instanz von V-LoL vor: V-LoL-Trains – eine visuelle Version eines klassischen Benchmarks der symbolischen KI, des Michalski-Zugproblems. Durch die Integration komplexer visueller Szenen und flexibler logischer Aufgaben in einem vielseitigen Rahmen bietet V-LoL-Trains eine Plattform zur Untersuchung einer breiten Palette von visuellen logischen Lernherausforderungen. Wir evaluieren verschiedene KI-Systeme, darunter traditionelle symbolische KI, neuronale KI und neuro-symbolische KI. Unsere Auswertungen zeigen, dass selbst modernste KI Schwierigkeiten hat, mit visuellen logischen Lernaufgaben umzugehen, und verdeutlichen die einzigartigen Vor- und Nachteile jeder Methodik. Insgesamt eröffnet V-LoL neue Wege, um die aktuellen Fähigkeiten in visuellen logischen Lernprozessen für KI-Systeme besser zu verstehen und zu verbessern.

Datensatz: https://huggingface.co/datasets/AIML-TUDA/v-lol-trains

LeoLM – First open German Foundation Language Model

LeoLM (Linguistically Enhanced Open Language Model) ist ein hochwertiges bilinguales (deutsch / englisch) Sprachmodell. Es basiert auf der LLama-2 Architektur und wurde mit einem umfangreichen, qualitativ hochwertigen deutschen Textkorpus trainiert und feinabgestimmt.

mehr lesen

Vortrainiert wurde LeoLM mit 2 Milliarden primär englischsprachigen Tokens und zusätzlich anhand von 65 Milliarden gezielt gefilterten und deduplizierten Token aus Webtexten des OSCAR-2301-Korpus. Die Feinabstimmung des Modells erfolgte anhand von sechs deutsch- oder deutsch-englischsprachigen Datensätzen.

Die Qualität des Modells wurde durch den Einsatz von linearer RoPE-Skalierung und Flash Attention 2 zur Verbesserung der Trainingseffizienz und Verdoppelung der Kontextlänge auf 8k Token verbessert.

Nachfolgend finden Sie eine detaillierte Beschreibung des Modells, die zugehörigen Repositories und entsprechende Chat-Demonstratoren.

Das Projekt wurde in Kooperation zwischen dem hessischen KI Servicezentrum und LAION gemeinnütziger e.V. entwickelt. Vielen Dank für die sehr gute Kooperation und Unterstützung.

Detaillierte Beschreibung: LeoLM: Igniting German-Language LLM Research | LAION

Demonstrator 7b: LeoLM Chat-Demonstrator

Repository 7b: LeoLM/leo-hessianai-7b · Hugging Face

Demonstrator 13b: LeoLM 13b Chat – a Hugging Face Space by LeoLM

Repository 13b: LeoLM/leo-hessianai-13b · Hugging Face

StripedHyena-7B – Long context LLM

Das StripedHyena7B Modell basiert auf der hybriden Hyena Architektur, die sich aus mehrköpfigen, gruppierten Abfragen und in Hyena-Blöcken angeordneten Gated Convolutions zusammensetzt und sich von den herkömmlichen Decoder-Only-Transformern unterscheidet.

mehr lesen

Diese Architektur ermöglicht

- eine kostengünstige Speicherdekodierung in Hyena-Blöcken durch Darstellung von Faltungen als Zustandsraummodelle (modale oder kanonische Form) oder als verkürzte Filter.

- Geringe Latenz, schnellere Dekodierung und höherer Durchsatz als bei Transformers.

- Verbesserung der Trainings- und Inferenz-optimalen Skalierungsgesetze im Vergleich zu optimierten Transformer-Architekturen wie Llama-2.

- Durch das Training auf Sequenzen von bis zu 32k können auch längere Prompts verarbeitet werden.

Hiermit ist StripedHyena 7B das erste alternative Modell, das mit den besten Open-Source-Transformern in Kurz- und Langkontextbewertungen konkurrenzfähig ist.

Das Projekt wurde in Kooperation zwischen dem hessischen KI Servicezentrum und Together Computer Inc. entwickelt. Vielen Dank für die sehr gute Zusammenarbeit und Unterstützung.

Detaillierte Beschreibung: Paving the way to efficient architectures: StripedHyena-7B, open source models offering a glimpse into a world beyond Transformers

Repository 13b Foundation model: togethercomputer/StripedHyena-Hessian-7B · Hugging Face

Repository 13b Chat model: togethercomputer/StripedHyena-Nous-7B · Hugging Face

Demonstrator: http://stripedhyena.hessian.ai/

Occiglot-7B-EU5 – Multilingual European LLM

Occiglot-7B-EU5 ist ein generatives Sprachmodell mit sieben Milliarden Parametern, welche die fünf wichtigsten EU-Sprachen (Englisch, Spanisch, Französisch, Deutsch und Italienisch) unterstützt. Es basiert auf Mistral-7B-v0.1 und wurde auf 293 Milliarden Token zusätzlicher mehrsprachiger und codierter Daten mit einer Blockgröße von 8.192 Token pro Probe trainiert.

mehr lesen

Bei dem Modell handelt es sich um ein allgemeines Basismodell, welches weder auf Befehle abgestimmt noch für Chats oder andere Anwendungen optimiert wurde.

Das Modell wurde in Kooperation zwischen dem Deutschen Forschungszentrum für Künstliche Intelligenz (DFKI) und dem hessischen KI Servicezentrum trainiert.

Repository: occiglot/occiglot-7b-eu5 · Hugging Face

Demonstrator: http://occiglot.hessian.ai/

LLavaGuard –Safeguards for Vision Dataset Curation and Safety Assessment

Wir stellen LlavaGuard vor, eine Familie von VLM-basierten Schutzmodellen, die einen vielseitigen Rahmen zur Bewertung der Sicherheit von visuellem Inhalt bieten. Insbesondere wurde LlavaGuard für die Datenanmerkung und den Schutz generativer Modelle entwickelt.

mehr lesen

Zu diesem Zweck haben wir einen hochwertigen visuellen Datensatz gesammelt und annotiert, der eine umfassende Sicherheitstaxonomie umfasst, mit der wir VLMs auf kontextbezogene Sicherheitsrisiken abstimmen. Als wesentliche Innovation enthalten die Antworten von LlavaGuard detaillierte Informationen, darunter eine Sicherheitsbewertung, die verletzten Sicherheitskategorien und eine ausführliche Begründung. Darüber hinaus ermöglichen unsere anpassbaren Taxonomiekategorien die kontextspezifische Ausrichtung von LlavaGuard auf verschiedene Szenarien. Unsere Experimente zeigen die Fähigkeiten von LlavaGuard in komplexen und realen Anwendungen. Wir stellen Checkpoints von 7B bis 34B Parametern zur Verfügung, die eine erstklassige Leistung demonstrieren, wobei selbst die kleinsten Modelle Baselines wie GPT-4 übertreffen. Wir machen unseren Datensatz und die Modellgewichte öffentlich zugänglich und laden zu weiterer Forschung ein, um den unterschiedlichen Bedürfnissen von Gemeinschaften und Kontexten gerecht zu werden.

Modell 7b: https://huggingface.co/AIML-TUDA/LlavaGuard-7B

Modell 13b: https://huggingface.co/AIML-TUDA/LlavaGuard-13B

Modell 34b: https://huggingface.co/AIML-TUDA/LlavaGuard-34B

Demonstrator: https://huggingface.co/spaces/AIML-TUDA/LlavaGuard

German LLama3

Das Modell Llama3-German-8B ist eine Weiterentwicklung von Metas Llama3, speziell für die deutsche Sprache. Mit 65 Milliarden hochwertigen, deutschsprachigen Tokens trainiert, zeigt es starke Leistungen in der Sprachverarbeitung und im Umgang mit komplexen deutschen Texten.

mehr lesen

Eine Besonderheit des Modells ist die Langkontext-Verarbeitung, die bis zu 32.000 Tokens umfasst, was es besonders effektiv für Aufgaben macht, bei denen längere Texte analysiert werden müssen.

Das Modell wurde zusätzlich mit speziellen Datensätzen für instruktionsbasierte Aufgaben feinabgestimmt und kann präzise Antworten auf Fragen liefern sowie komplexe Aufgabenstellungen verstehen. Diese Fähigkeiten sind besonders nützlich für die Entwicklung von Anwendungen im Bereich der natürlichen Sprachverarbeitung in deutschsprachigen Regionen. Durch die gezielte Anpassung auf die deutsche Sprache reduziert das Modell die Abhängigkeit von internationalen Technologien und stärkt die Forschung und Entwicklung im Bereich der KI innerhalb des deutschsprachigen Raums.

Modell: https://huggingface.co/DiscoResearch/Llama3-German-8B-32k

DiscoLM

Das DiscoLM-Modell von DiscoResearch ist ein fortschrittliches KI-Sprachmodell, das speziell auf die deutsche Sprache und deren Eigenheiten abgestimmt ist.

mehr lesen

Basierend auf dem Mistral-Modell, wurde DiscoLM mit Milliarden deutschsprachiger Daten trainiert und zeichnet sich durch seine exzellente Sprachverständnis und präzise Textgenerierung aus. Es wurde entwickelt, um in deutschsprachigen Anwendungen wie der Verarbeitung natürlicher Sprache, Textgenerierung und instruktionsbasierten Aufgaben zu glänzen.

Ein besonderer Vorteil von DiscoLM ist seine Fähigkeit, im Vergleich zu vielen gängigen englischbasierten Modellen, den spezifischen Anforderungen der deutschen Sprache gerecht zu werden. Dadurch trägt das Modell maßgeblich zur Stärkung der KI-Souveränität in Deutschland bei, indem es die Abhängigkeit von internationalen, englischsprachigen Modellen reduziert und gleichzeitig die Entwicklung lokal angepasster KI-Lösungen fördert. Zudem zeigt DiscoLM hervorragende Leistung in der Feinabstimmung für konkrete Aufgaben wie Fragebeantwortung und Informationsverarbeitung, was es zu einem wichtigen Werkzeug für Unternehmen und Forschung macht.

Durch die enge Zusammenarbeit mit Partnern wie LAION und Hessian.AI wurde dieses Modell gezielt für die Anforderungen der deutschen Sprachgemeinschaft optimiert.

Aktuelle Forschungsaktivitäten

Unsere Doktorranden forschen hierbei:

Intelligent data documentation and data cleansing [Lukas Helff]

Die Qualität und Größe von Trainingsdatensätzen sind entscheidend für die erfolgreiche Entwicklung von modernen KI-Anwendungen. Datendokumentation und Daten-Cleansing spielen hierbei eine zentrale Rolle, insbesondere mit dem Aufkommen beliebter Modelle wie GPT-4, die in verschiedenen Bereichen an Bedeutung gewinnen. Mit der wachsenden Autonomie dieser KI-Systeme erweitern sich ihre gesellschaftlichen, wissenschaftlichen und industriellen Auswirkungen, was hochwertige Daten zur Vermeidung von Verzerrungen und Stereotypen erforderlich macht.

mehr lesen

Die manuelle Annotation großer Datensätze ist nicht nur fehleranfällig, sondern auch mühsam und mit hohen Humanressourcen verbunden. Intelligente Datendokumentation und Datenbereinigung stellen daher zentrale Lösungen für diese Herausforderungen dar, mit dem Ziel, die Vorbereitung hochwertiger Datensätze für KI-Anwendungen zu optimieren.

In diesem Zusammenhang konzentriert sich dieses Projekt auf das Potenzial von Maschinen, bei der Dokumentation potenziell unangemessener Inhalte zu assistieren, indem das in Transformer-Modellen gespeicherte Wissen genutzt wird. Dies könnte den menschlichen Arbeitsaufwand bei der Datenvorbereitung erheblich reduzieren.

Hierbei ist es das Ziel, intelligente Datendokumentation und Daten-Cleansing zu entwickeln, welche als Services angeboten werden können, um unangemessenen Content zu erkennen. Geplante Schritte umfassen das Trainieren von Dokumentationsmodellen für Bilder, die Erweiterung auf Text- und tabellarische Daten sowie die automatische Dokumentation von gemischten Daten. Durch generativen und axiomatischen Abgleich der Dokumentationsmodelle sowie die Bereitstellung als Service wird die Praxistauglichkeit und Marktfähigkeit sichergestellt.

Die Ergebnisse dieses Forschungsprojekts werden im KI-Servicezentrum als Module für die Datendokumentation, -bereinigung und Qualitätssicherung eingesetzt.

Adaptation of large (vision) language models [Christopher Tauchmann]

Dieses Projekt konzentriert sich auf die Anpassung großer (Bildverarbeitungs-) Sprachmodelle an nachgelagerte Aufgaben und auch an allgemeinere Anforderungen. Um dieses Ziel zu erreichen, verfolgen wir mehrere Forschungslinien.

mehr lesen

Ein besonderes Interesse liegt in der Verwendung von modularen und parameter-effizienten Transfer-Learning-Methoden. Solche Methoden aktualisieren nur einen Bruchteil der Parameter eines Modells, fügen eine kleine Anzahl von trainierbaren Parametern hinzu oder verwenden bereits vorhandene Parameter wieder. Andere Methoden lernen kleinere Modelle aus größeren Modellen oder kombinieren mehrere Module.

In diesem Sinne ist die Verwendung verschiedener Prompting-Techniken, d.h. die Analyse und Nutzung von In-Context-Learning-Fähigkeiten (bei denen ein Modell aus Beispielen in der Eingabeaufforderung lernt), sehr vielversprechend, um Modelle on-the-fly anzupassen; oder im Falle von Instruktionstuning als verwandte Lerntechnik, um Modelle auf bestimmte Anforderungen einzustellen. Retrieval augmented generation nutzt externes Wissen, um die Fähigkeiten eines Modells zu erweitern.

Darüber hinaus tauchen wir tief in Modellarchitekturen ein, d. h. wir interpretieren und bearbeiten modellinterne Repräsentationen. Dies kann z. B. durch die Verfolgung des Informationsflusses oder die Analyse einzelner Modellkomponenten geschehen. Ein solcher Ansatz betrachtet die Module des Modells als Teil eines Stroms, der an jedem beliebigen Punkt auf die Eingabe zurückgeführt werden kann, wobei die Bearbeitung des Stroms an bestimmten Stellen zu messbaren Ergebnissen führt.

Wir finden es interessant zu sehen, welche Aufgaben von verschiedenen Ansätzen profitieren. Da die heutigen sehr großen Modelle bei einer großen Anzahl von Aufgaben sehr gut abschneiden, sind wir im Falle von reinen Sprachmodellen bei den meisten, wenn nicht sogar bei allen traditionelleren NLP-Aufgaben besonders an ihren Argumentationsfähigkeiten interessiert.

AI hardware for Data Processing [Nils Boeschen]

Im Rahmen dieses Projekts wird untersucht wie moderne KI Hardware (z.B. GPUs) genutzt werden können, um Datenverarbeitungsaufgaben (data processing) mit intensivem Festplatten- und Netzwerkzugriff zu beschleunigen.

mehr lesen

GPUs sind leistungsstarke Recheneinheiten für viele daten- und verarbeitungsintensive Arbeitslasten und übertreffen CPUs bei diesen Aufgaben um mehrere Größenordnungen. Aus diesem Grund wird untersucht, wie die Geschwindigkeitsvorteile von GPUs für die Datenverarbeitung auf modernen Speichern und in schnellen Netzwerken genutzt werden können.

Die bisherigen Ergebnisse zeigen, dass GPUs mit Techniken wie schwergewichtiger Dekompression und Pruning eine erhebliche Steigerung der Datenlast und der Verarbeitungsbandbreite erreichen können, welche heute für CPU-Systeme unerreichbar ist.

Scalable Data Processing using Tensor Runtimes [Nils Boeschen]

Im Rahmen dieses Projekts wird untersucht, wie aktuelle Tensor-Frameworks wie PyTorch und Tensorflow als Plattformen für die verteilte Abfrageverarbeitung genutzt werden können. Diese Frameworks sind als universelle Abfrageverarbeitungsprogramme interessant, da sie eine Vielzahl von Hardwaretypen (CPUs, GPUs, TPUs, etc.), Datenformaten und Datenoperationen sofort unterstützen.

mehr lesen

Es hat sich gezeigt, dass SQL-Abfragen für Einzelknoten-Setups in eine Reihe von Operationen umgewandelt werden können, die mit Tensor-Laufzeiten vergleichbar sind, und dass die Performanz dieser Art der Ausführung vergleichsweise hoch ist. Es ist jedoch noch unklar, ob diese Vorteile auch in einer vernetzten Umgebung zum Tragen kommen.

Da die verteilte Abfrageverarbeitung effiziente schlüsselbasierte Netzwerk-Mischungen, die Überlappung von Netzwerk- und Rechenoperationen sowie die Behandlung von Schräglagen erfordert, ist die Transformation nicht trivial. In diesem Forschungszweig wird untersucht, wie verteilte Abfragen so transformiert werden können, dass sie mit denselben Vorteilen effizient über Tensor-Frameworks ausgeführt werden können.

Code Transformers [Mert Tiftikci]

Das Projekt Code Transformers konzentriert sich auf das Verständnis und die Verbesserung generativer KI-Modelle für Programmcode. Die erstellten fortschrittlichen Code-Modelle können Entwicklern bei ihren Aufgaben helfen, ebenso wie ihren Kollegen im Sinne des Pair Programming. Es reicht nicht aus, kompilierbaren und leicht lesbaren Code zu erzeugen. Er muss auch die vom Entwickler aufgeworfenen Probleme lösen und dabei die Industriestandards auch bei neu eingeführten Projekten und Bibliotheken einhalten. Dies kann erreicht werden, wenn KI-Modelle den Code syntaktisch und semantisch verstehen können.

mehr lesen

Derzeitige Hochleistungsmodelle verfügen über Blackbox-Strukturen, die aus riesigen Datenmengen lernen, die durch das Sammeln von Code in der „freien Wildbahn“ entstanden sind. Solche Datensätze enthalten anfälligen Code oder sogar Malware. Es ist auch erwähnenswert, dass viele dieser Modelle aus diesen Datensätzen lernen, indem sie die Vervollständigung eines bestimmten Codes sequenziell vorhersagen und dabei die reichhaltige Struktur, die er enthält, außer Acht lassen.

Das Projekt Code Transformers zielt darauf ab, effiziente Code-Modelle zu entwickeln, indem zunächst die Tiefe ihres Verständnisses und ihre Grenzen untersucht werden. Anschließend werden anpassbare und modulare Strukturen entworfen, die verschiedene Techniken wie multimodales Training oder neurosymbolisches Lernen nutzen können. Solche Modelle können reichhaltige Metadaten nutzen, die mit dem Code verknüpft sind; sie passen sich den Benutzerpräferenzen an und sind vertrauenswürdiger, da sie Erklärungen für ihre Generationen liefern können.

Use of structure and multimodality in transformer models [Falko Helm]

In dem von Hessian.AI geförderten Forschungsprojekt „Structure and Multimodality for Transformer Networks“ geht es um den Umgang mit Dokumenten wie PDF- und XML-Dateien (z.B. MS Word).

Früher haben Systeme zur Sprachverarbeitung von Dokumenten alles außer dem reinen Text verworfen. Ziel dieses Projekts ist es, direkt mit Dokumenten ohne jegliche Vorverarbeitung zu arbeiten. Dies beinhaltet die Berücksichtigung der verschiedenen Modalitäten (Text, Bilder, Tabellen, Diagramme) sowie deren Zusammenspiel in Form von Layout und expliziten Links.

mehr lesen

Um den Hintergrund zu verdeutlichen, wollen wir den Projekttitel Wort für Wort erklären. „Multimodalität“ bedeutet, dass das Dokument auch andere Elemente als Text enthält. Dies können zum Beispiel Bilder, Tabellen oder Diagramme sein. Die Modalitäten Video und Audio werden nicht berücksichtigt, da sie in Geschäftsdokumenten eher selten vorkommen. Wichtig ist, dass Multimodalität bedeutet, dass das Zusammenspiel der Modalitäten komplex ist, d. h. wir gehen über simple Paare von Bild und entsprechender Textbeschriftung hinaus.

Der Begriff „Struktur“ bezieht sich auf alles, was über Text als einfache Zeichenfolge hinausgeht. Struktur kann sich in Form von Versumbrüchen in einem Gedicht, Kapiteln in einem Buch oder Spalten in einer Zeitung manifestieren. Darüber hinaus beschreibt der Begriff „Struktur“ auch die Beziehungen zwischen Text- und Nicht-Text-Elementen eines Dokuments. Dies kann implizit durch die räumliche Anordnung oder explizit durch Verweise auf Tabellen und Diagramme erfolgen.

Ein „Transformer“ ist eine spezielle Art von neuronalem Netz (d.h. ein Modell, das aus Daten lernen kann) und kann für Analysen und Vorhersagen verwendet werden. Im Sprachbereich waren die jüngsten Durchbrüche (z. B. ChatGPT) hauptsächlich auf diese Architektur zurückzuführen. Derzeit stößt der Standard-Transformer an die Grenzen der Hardware, da seine Schlüsselkomponente, die so genannte Self-Attention, schlecht mit der Sequenzlänge skaliert. Daher wollen wir uns auch mit neueren Modellen befassen, die ohne attention auskommen, z. B. state-space Modelle wie Mamba.

Das Feld der KI entwickelt sich jedoch sehr schnell, so dass diese Pläne vorläufig sind und schon morgen überholt sein können.

Support for non-standard DNNs [Tim Noack]

Trotz ihrer weiten Verbreitung haben herkömmliche neuronale Netze mit der Modellierung von Unsicherheiten zu kämpfen und erfordern umfangreiche Trainingsdaten. Diese Einschränkungen können problematisch sein, wenn ihre Vorhersagen beispielsweise verständlich sein müssen. Probabilistische Schaltungen (PC) bieten eine überzeugende Alternative zu neuronalen Netzen.

mehr lesen

Summenproduktnetze (SPNs), ein wichtiges Mitglied der PC-Familie, zeichnen sich durch ihre effiziente Inferenzfähigkeit, die Fähigkeit, mit relativ wenigen Daten und Hyperparametern trainiert zu werden, und ihre Fähigkeit, die Unsicherheit ihrer Vorhersagen zu modellieren, aus. SPNs auf Rechenplattformen wie CPUs, GPUs und FPGAs einzusetzen, stellt jedoch eine Herausforderung dar. Insbesondere passen diese Netze aufgrund ihrer spärlichen Verbindungen und der Konvergenz zu einem einzigen Ausgangsknoten nicht gut zu massiv-parallelen Architekturen.

Dieses Projekt befasst sich mit diesen Problemen durch die Entwicklung eines MLIR-basierten SPNC-Compilers. Der SPNC-Compiler soll die Lücke zwischen fortschrittlichen Hardware-Architekturen und der Zugänglichkeit dieser leistungsstarken Modelle für KI-Praktiker ohne Hardware-Kenntnisse schließen.

Diese Integration maximiert den Nutzen der Hardware und minimiert die notwendige Lernkurve für KI-Forscher und Entwickler. Durch die effiziente Berechnung von SPNs auf spezialisierter Hardware, wie FPGAs und IPUs, eröffnet unser Projekt neue Wege für KI-Anwendungen.

Aktuelle Anwendungsprojekte

ETH Text-to-Music

In Kooperation mit der ETH Zürich wird ein Text-to-Music Diffusion-Model mit 1-3 millarden Parametern trainiert, welches auf Basis von Text-Prompts und Parametern wie Tempo & Schlagworten Musikstücke erzeugt.

Als Basis für das Training des Modells dient ein hochwertiger Teildatensatz des FMA music datasets und des Jamendo royalty-free music datasets.

Im Ergebnis des gemeinsamen Projekts sollen das trainierte Modell sowie die Trainingsdaten unter Open-Source-Lizenz publiziert werden.

Kooperationspartner: Luca Lanzendörfer, Distributed Computing Group, ETH Zürich

Haris‘ MorphPiece Tokenisation

In Kooperation mit Haris Jabbar validieren und evaluieren wir ein neuartiges Tokenisierungsschema für die englische Sprache, das morphebasierte Segmentierung mit Byte Pair Encoding integriert, um NLP-Modelle zu verbessern.

Ziel ist es, einen stärker linguistisch ausgerichteten Tokenisierungsmechanismus zu testen, der das Verständnis des Modells für sprachliche Nuancen verbessert – und somit auch die Leistung des Modells. Gleichzeitig soll er die effizientere Handhabung von Sprachen mit reichhaltiger Morphologie (im Vergleich zu Methoden, die sich nur auf statistische Analysen stützen) unterstützen.