RAI

Reasonable Artificial Intelligence

PostDoc Positionen ausgeschrieben

Jede:r RAI Postdoc übernimmt eine zentrale Rolle beim Aufbau, der Koordination und Organisation eines der vier Forschungsbereiche und verbindet dies mit eigenständiger, international sichtbarer Forschung. Zu den Aufgaben gehören zudem Lehre und Betreuung sowie die Mitwirkung bei der Einwerbung neuer Forschungsprojekte. Darüber hinaus trägt die Stelle zum strategischen und organisatorischen Austausch mit der Verwaltung des Exzellenzclusters bei und stärkt die Vernetzung mit relevanten Stakeholdern.

Es sind bis zu 4 Stellen als wissenschaftliche/r Mitarbeiter/in / Postdoktorand/in (m/w/d) im Exzellenzcluster „Reasonable AI“ zu besetzen. Die Bewerbungsfrist ist auf den 30. März 2026 verlängert.

Über RAI

In den letzten zehn Jahren hat Deep Learning (DL) zu bahnbrechenden Fortschritten in der künstlichen Intelligenz geführt, und trotzdem haben aktuelle KI-Systeme noch immer bemerkenswerte Schwachstellen.

(1) Sie werden auf „unvernünftige“ Weise entwickelt und eingesetzt und erfordern unvernünftig große Modelle, Daten, Berechnungen und Infrastrukturen, so dass letztlich einige wenige große Unternehmen mit den erforderlichen Ressourcen eine Monopolstellung einnehmen;

(2) Sie können nicht logisch denken oder leicht mit unbekannten Situationen und differenzierten Zusammenhängen umgehen, und es fehlt ihnen auch an gesundem Menschenverstand und Abstraktionsvermögen;

(3) Sie verbessern sich weder kontinuierlich im Laufe der Zeit, noch lernen sie durch Interaktionen oder können sich schnell anpassen – sie müssen ständig angepasst und neu trainiert werden, was zu unangemessenen wirtschaftlichen und ökologischen Kosten führt. Solch „unvernünftiges“ Lernen macht sie anfällig und kann sogar schädlich für die Gesellschaft sein; dies muss im Kern behoben werden, nicht nur durch eine brachiale Skalierung der Ressourcen oder die Anwendung von Pflastern.

Mit hessian.AI streben wir eine neue Generation von KI an, die wir Reasonable Artificial Intelligence (RAI) nennen. Diese neue Form der KI wird auf „vernünftigere“ Weise lernen, wobei die Modelle dezentral trainiert werden, sich im Laufe der Zeit kontinuierlich verbessern, ein abstraktes Wissen über die Welt aufbauen und über eine intuitive Fähigkeit verfügen, zu denken, zu interagieren und sich an ihre Umgebung anzupassen. Diese Idee der vernünftigen Künstlichen Intelligenz wurde als Exzellenzcluster vorgeschlagen.

Die Grundlagen für das Exzellenzcluster „Reasonable Artificial Intelligence – RAI“ (EXC 3057) im Rahmen der Exzellenzstrategie des Bundes und der Länder werden in 3AI gelegt. 3AI wird als Clusterprojekt vom Hessischen Ministerium für Wissenschaft, Forschung und Kunst von 2021 bis 2025 gefördert. Darüber hinaus tragen fünf LOEWE-Professuren und zwei Humboldt-Professuren zur Idee einer „vernünftigen“ KI bei. hessian.AI, das mit rund 38 Mio. Euro unterstützt wird, stellt die Rechenleistung zur Verfügung, um die Forschung an einer „vernünftigen“ KI durchzuführen.

RAI wird koordiniert von Prof. Kristian Kersting, Prof. Mira Mezini und Prof. Marcus Rohrbach (alle TU Darmstadt).

RAI-Struktur

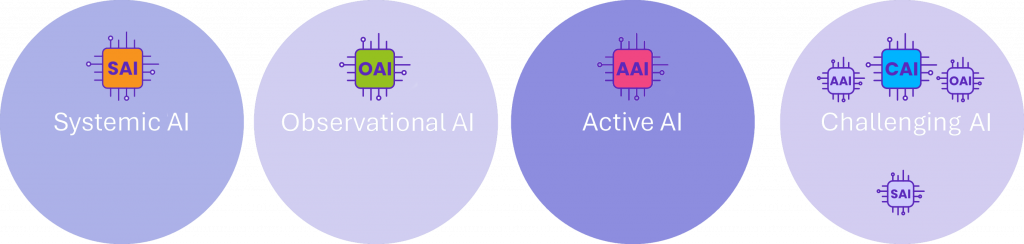

RAI ist in vier Forschungsbereiche „Labs“ gegliedert, die sich jeweils mit einem wichtigen Aspekt von RAI befassen: (1) Das Forschungslabor „Systemic AI“ arbeitet an Software- und Systemmethoden, die ein modulares, kollaboratives, dezentralisiertes, interaktives und inkrementelles Training von RAIs ermöglichen und ihre effiziente Integration in bestehende große Softwaresysteme unterstützen; (2) „Observational AI“ überdenkt kontextuelles Lernen und bringt verschiedene KI-Regime zusammen, um Wissen mit gesundem Menschenverstand einzubringen; (3) „Active AI“ konzentriert sich auf kontinuierliches und adaptives lebenslanges Lernen mit aktiver Exploration; (4) „Challenging AI“ schließlich entwickelt Herausforderungen und Benchmarks, um die Entwicklung von RAI zu überwachen und zu bewerten. Die PIs aus verschiedenen Disziplinen werden als multidisziplinäre Teams zusammenarbeiten, um Grenzen zu überwinden, die Vielfalt zu fördern und ein neues, lernzentriertes Computerparadigma zu schaffen, das die Art und Weise, wie wir KI entwickeln und nutzen, verändern wird.

Systemic AI

„Systemic AI“ (SAI) zielt darauf ab, systemische Grundlagen für RAI zu entwickeln, um die Effizienz und Qualität des Aufbaus und der Einbettung von RAI in groß angelegte Softwaresysteme zu erhöhen. Wir werden die Abstraktionsebene anheben, ähnlich wie die High-Level-Programmierung in der Vergangenheit die Entwicklungsanstrengungen von Low-Level-Problemen wegverlagert und die Klasse der Entwickler erweitert hat, die anspruchsvolle Softwaresysteme erstellen können. Zu diesem Zweck werden wir die differenzierbare Programmierung auf die multiparadigmatische neurosymbolische Programmierung ausdehnen und verallgemeinern und High-Level-Programmierabstraktionen auf hybride KI-Architekturen abbilden, die aus vielen KI-Modulen bestehen. Entscheidend ist, dass wir neurosymbolische Programmiergrundlagen anstreben, die von Haus aus kollaboratives, dezentrales, interaktives und inkrementelles Lernen unterstützen. Dies wird nicht nur den Nutzen von Daten mit Datenschutz- und Eigentumsvorschriften verbessern, sondern auch eine effiziente Nutzung von Rechenressourcen ermöglichen und die Entwicklung von KI unterstützen, die auch nach dem Einsatz leicht verändert werden kann. Wir werden auch über die reine Programmierung und Einbettung von RAI hinausgehen und sowohl Kernbausteine von Software-Stacks (wie Datenbanken) als auch Benutzeroberflächen überdenken und neu gestalten, so dass sie ihre Funktionalität aktiv an RAI-Software anpassen können und RAI in die Lage versetzen, aus der Interaktion mit der Außenwelt zu lernen.

Observational-KI

„Observational AI“ (OAI) überdenkt die Algorithmen der beobachtenden KI von Grund auf und legt neue algorithmische Grundlagen für die rechnerische und mathematische Modellierung kontextbezogener Lernalgorithmen. Da ein Bestandteil allein nicht ausreicht, um RAIs zu entwerfen, werden wir uns auf Algorithmen konzentrieren, die aus vielen KI-Modulen aus maschinellem Lernen, Optimierung und Schlussfolgerungen zusammengesetzt werden können; die zusammengesetzten Modelle können beispielsweise raum-zeitlich, physikalisch, domänenspezifisch oder kognitiv sein. Eine zentrale Herausforderung ist die Zusammenführung verschiedener, derzeit getrennter KI-Regelungen. So wird z. B. die Wahrnehmung auf niedriger Ebene (z. B. das Erkennen eines Straßenschilds) in der Regel durch standardmäßiges maschinelles Lernen bewältigt, während für Schlussfolgerungen auf höherer Ebene (z. B. die Schlussfolgerung, dass ein Straßenschild mit 120 km/h in einem Dorf keinen Sinn ergibt) logische und probabilistische Darstellungen verwendet werden. Es ist eine Herausforderung, solche unterschiedlichen Systeme zusammenzubringen; eine andere besteht darin, Wissen mit gesundem Menschenverstand in differenzierbare Modelle einzubringen. Die gemeinsame Bearbeitung beider Aspekte wird es den RAI ermöglichen, Beobachtungsaufgaben in offenen Welten zu lösen, indem sie Daten mit kontextbezogenem und beschreibendem Wissen kombinieren. Darüber hinaus werden wir symbolisch-deskriptive Modelle integrieren, die verwendet werden, um erklärbare Ansätze für beobachtende KI zu entwickeln, da symbolische Erklärungen den Austausch von Wissen und die Koordinierung von Aufgaben mit anderen Agenten ermöglichen, einschließlich. Menschen.

Active AI

„Active AI“ (AAI) überdenkt lebenslanges Lernen und Handeln auf der Grundlage von Agenten mit Verstärkungslernen, die sich in komplexen (virtuellen) Umgebungen mit simulierter Physik entwickeln. Diese Agenten werden beobachtende KI für multimodale Wahrnehmung sowie Planung und Lernen nutzen und durch wissens- und kompetenzbasierte Erkundung der Welt angetrieben werden. Auf diese Weise werden sie in der Lage sein, mit der Welt zu interagieren, wobei sie immer weniger von außen überwacht werden. Letztlich können die Agenten ihre eigenen Lernziele definieren und üben, wie sie diese erreichen können. Eine zentrale Frage, die in enger Zusammenarbeit mit dem Bereich Systemische KI beantwortet werden soll, lautet: Wie können abstrakte Repräsentationen und Konzepte, aus denen die Agenten ihre Lernziele ableiten können, selbst generiert werden? Unsere Hypothese ist, dass induktive Verzerrungen – Wissen und Annahmen, die der Lernende zur Vorhersage nutzt – der Schlüssel zur effizienten Nutzung „weniger Daten“ sein werden. Wir stellen uns vor, dass die Ausstattung von „Startalgorithmen“ mit diesen Eigenschaften dazu beiträgt, Invarianten zu erlernen, die es dem Agenten wiederum ermöglichen, über verschiedene Umgebungen und Aufgaben hinweg zu generalisieren. Dies wird wahrscheinlich zu schnelleren, robusten und skalierbaren Algorithmen für kontinuierliches und verstärkendes Lernen führen. Wir erwarten auch neuartige Lernalgorithmen, die weniger Handarbeit erfordern und leichter an neue Aufgaben angepasst werden können. Solche Algorithmen können Einblicke in die Eigenschaften ihrer Komponenten bieten, z. B. Zustands- und Aktionsdarstellung, Belohnungen, Übergangsmodelle, Strategien und Wertfunktionen.

Challenging AI

„Challenging AI“ (CAI) nutzt und entwickelt Herausforderungen und Benchmarks, um die Grenzen von KI-Ansätzen aufzuzeigen und zu quantifizieren und um RAI zu orientieren. Wenn sie angemessen umgesetzt und interpretiert werden, ermöglichen Benchmarks der breiteren Gemeinschaft, die KI-Technologie besser zu verstehen und ihre Entwicklung zu beeinflussen. Denken Sie z. B. daran, wie Stiftungsmodelle in letzter Zeit KI-Anwendungen vorangebracht haben. Im Kern basieren sie oft auf Sprachmodellen, d.h. auf Blackboxen, die Daten aufnehmen und z.B. natürlichen Text, Bilder oder Code erzeugen. Trotz ihrer Einfachheit können sie, nachdem sie an umfangreichen Daten in einem riesigen Maßstab trainiert wurden, an eine Vielzahl von nachgelagerten Szenarien angepasst (z. B. aufgefordert oder fein abgestimmt) werden. Da es weder möglich ist, alle Szenarien noch alle Desiderate zu berücksichtigen, die sich auf Gründungsmodelle beziehen (könnten), zielen wir darauf ab, die Unvollständigkeit von Gründungsmodellen und anderen KI-Modellen anzuerkennen, um RAI-Modelle zu motivieren und zu hinterfragen. Die Ausweitung der Bewertung ist ein anhaltender Trend, der auch in der HELM-Initiative zusammengefasst ist. Die Ergebnisse zeigen, dass eine beträchtliche Lücke zwischen KI und menschlichem Lernen besteht. Wir werden bestehende kognitionswissenschaftliche Herausforderungen (z. B. Winograd-Probleme oder Kandinsky-Muster) sammeln, an denen aktuelle KI-Systeme noch scheitern, und sie für die Überwachung nutzen sowie auf die multimodale und kontinuierliche Umgebung verallgemeinern. Entscheidend ist, dass wir die Kognitionswissenschaft nutzen, um die Entwicklung vernünftigerer KI-Systeme anzuleiten und zu informieren.

SprecherInnen

„Die gegenwärtigen KI-Systeme zeigen trotz beeindruckender Fortschritte erhebliche Schwächen. Anwendungen wie ChatGPT können zwar umfangreiche Texte zu komplexen Themen schreiben, lassen aber den gesunden Menschenverstand vermissen. Sie sind oft nicht in der Lage, vielschichtige Zusammenhänge zu verstehen und erfordern enorme Ressourcen. Eine wirklich vernünftige KI, die Risiken minimiert und effizient arbeitet, bleibt eine Herausforderung, der wir uns mit ‚Reasonable AI‘ und bei hessian.AI stellen.“ Mira Mezini

„In einer Welt, in der technologische Abhängigkeiten zunehmend geopolitische Spannungen verstärken, ist die Entwicklung einer europäisch-souveränen Künstlichen Intelligenz von entscheidender Bedeutung. Europa muss in der Lage sein, eigene Standards zu setzen und unabhängige, vertrauenswürdige Technologien zu entwickeln, um sowohl wirtschaftliche als auch gesellschaftliche Resilienz zu gewährleisten. Hier setzt ‚Reasonable AI‘ an. Eine vernünftige KI der nächsten Generation.“ Kristian Kersting

„Wir sind davon überzeugt, dass RAI die Zukunft der KI in Deutschland und weltweit gestalten wird. Neue, effiziente Sprachmodelle, zuletzt DeepSeek, haben gezeigt, wie schnell und effizient in der KI-Entwicklung Fortschritte erzielt werden können. Diese Modelle eröffnen allerdings nicht nur technologische und ressourcenschonende Möglichkeiten, sondern verdeutlichen auch die Notwendigkeit, KI vertrauenswürdig und vernünftig zu gestalten. Europa hat hier die einzigartige Chance, eine Vorreiterrolle einzunehmen, indem es Innovation mit ethischen Standards, Effizienz und Transparenz verbindet.“ Marcus Rohrbach

Forschende

-

Angela Yu

-

Anna Rohrbach

-

Carlo d’Eramo

-

Carsten Binnig

-

Constantin Rothkopf

-

Emtiyaz Khan

-

Gemma Roig

-

Georgia Chalvatzaki

-

Heinz Koeppl

-

Hilde Kühne

-

Iryna Gurevych

-

Isabel Valera

-

Jan Gugenheimer

-

Jan Peters

-

Justus Thies

-

Kristian Kersting

-

Marcus Rohrbach

-

Martin Mundt

-

Mira Mezini

-

Simone Schaub-Meyer

-

Stefan Roth

-

Susann Weißheit

Fellows

Wissenschaftsmanagement und Verwaltung

Leitende Institution

Institutionen der beteiligten Wissenschaftler:innen

- Technische Universität Darmstadt (Binnig, Carsten; Chalvatzaki, Georgia; Gugenheimer, Jan; Gurevych, Iryna; Kersting, Kristian; Khan, Emtiyaz; Koeppl, Heinz, Mezini, Mira; Peters, Jan; Rohrbach, Anna; Rohrbach, Marcus; Roth, Stefan; Rothkopf, Constantin; Schaub-Meyer, Simone; Thies, Justus; Yu, Angela)

- Justus-Maximilians Universität Würzburg (D’Eramo, Carlo)

- Goethe-Universität Frankfurt am Main (Roig, Gemma)

- Universität Tübingen (Kuehne, Hilde)

- Universität des Saarlandes (Valera, Isabel)

- Universität Bremen (Mundt, Martin)

Institutionelle Kooperationspartner